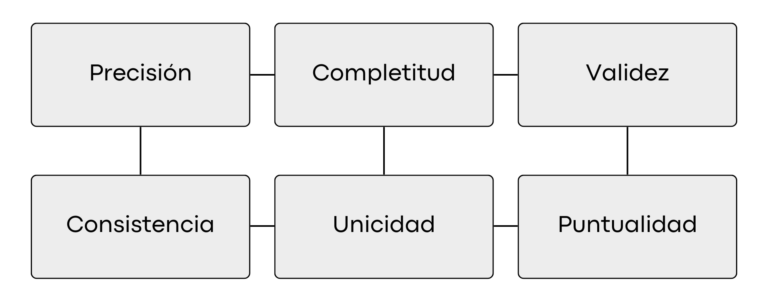

En la era actual de la transformación digital, los datos se han convertido en uno de los activos más valiosos para las empresas. La ciencia de datos se ha establecido como una disciplina fundamental para aprovechar el potencial de estos datos y obtener información valiosa para la toma de decisiones. Sin embargo, la calidad de los datos es un aspecto fundamental que a menudo se pasa por alto pero que puede tener un impacto significativo en los resultados de los proyectos de ciencia de datos. La calidad de los datos no se limita a la precisión y la integridad, sino que abarca una serie de criterios clave que garantizan que los datos sean confiables y útiles. Estos criterios incluyen la precisión, que asegura que los datos reflejen con precisión la realidad; la completitud, que garantiza que todos los datos necesarios estén disponibles; la consistencia, que asegura que los datos sean uniformes en todas las aplicaciones y redes; la validez, que asegura que los datos se recopilen de acuerdo con reglas y parámetros definidos; la unicidad, que garantiza que no haya duplicaciones ni superposiciones de valores; y la puntualidad, que asegura que los datos estén disponibles cuando se necesiten. Estos criterios son fundamentales para garantizar que los datos utilizados en los proyectos de ciencia de datos sean confiables y puedan generar insights valiosos para las organizaciones.

1. Precisión

La precisión de los datos es un aspecto crucial de la calidad de los mismos. Se refiere a la capacidad de los datos para reflejar con exactitud situaciones del mundo real. En otras palabras, datos precisos son aquellos que son correctos y están libres de errores o inexactitudes. Para que los datos se consideren precisos, deben coincidir con la verdad o realidad de la situación que describen. Esto significa que los valores, medidas y descripciones en los datos deben ser lo más cercanos posible a los valores y condiciones reales. Por ejemplo, si un conjunto de datos contiene información sobre la población de una ciudad, la precisión de los datos dependerá de qué tan cerca los números de población reportados coincidan con los números de población reales. La verificabilidad es un concepto importante relacionado con la precisión. Los datos verificables son aquellos cuya precisión puede ser confirmada o validada mediante una fuente confiable e independiente. Esto asegura que los datos no solo sean precisos, sino también confiables. Por ejemplo, si un conjunto de datos contiene información financiera, la precisión de los datos se puede verificar comparándolos con registros o estados financieros oficiales.

Garantizar la precisión de los datos es crucial porque los datos inexactos pueden llevar a conclusiones incorrectas, toma de decisiones deficientes y, en última instancia, a consecuencias negativas para las organizaciones. Para mantener la precisión de los datos, es importante utilizar fuentes de datos confiables, validar los datos mediante la verificación cruzada con otras fuentes e implementar controles y procesos de calidad de datos.

2. Completitud

La completitud de los datos es un aspecto fundamental de su calidad y se refiere a la medida en que los datos son capaces de proporcionar de manera efectiva todos los valores requeridos que están disponibles. En otras palabras, la completitud se trata de asegurar que no falten datos importantes y que todos los valores necesarios estén presentes en el conjunto de datos. Para que los datos sean considerados completos, deben incluir todos los campos y registros necesarios para cumplir con los requisitos del análisis o aplicación específica. Por ejemplo, si se está analizando un conjunto de datos sobre ventas, la completitud requeriría que cada registro tenga valores para campos como la fecha de la venta, el cliente, el producto vendido y el monto de la venta. La completitud es crucial porque los datos incompletos pueden llevar a análisis erróneos o sesgados, lo que a su vez puede resultar en decisiones incorrectas. Para garantizar la completitud de los datos, es importante tener en cuenta la fuente de los datos y asegurarse de que se estén recopilando todos los valores necesarios. Además, se pueden utilizar técnicas de limpieza de datos para identificar y completar los datos faltantes, como la imputación de valores o la eliminación de registros incompletos.

3. Consistencia

La consistencia de los datos se refiere a la uniformidad de los mismos a medida que se desplazan a través de redes y aplicaciones. Esto significa que los mismos valores de datos almacenados en diferentes ubicaciones no deben entrar en conflicto entre sí. En otras palabras, los datos deben ser coherentes y mantener su integridad y significado a lo largo de todo su ciclo de vida y en todas las aplicaciones y sistemas en los que se utilizan. Por ejemplo, si un sistema almacena la edad de un cliente como 30 años en un lugar y como 35 años en otro, habría una inconsistencia de datos. Esto podría llevar a errores en el análisis de los datos y a decisiones erróneas basadas en esa información incorrecta. Para garantizar la consistencia de los datos, es importante establecer estándares y reglas de negocio claras para el almacenamiento y manipulación de los datos. Además, se pueden utilizar herramientas y tecnologías que aseguren la coherencia de los datos a lo largo de su vida útil, como bases de datos relacionales con integridad referencial, o el uso de servicios de mensajería para garantizar la consistencia de los datos en aplicaciones distribuidas. La consistencia de los datos es fundamental para garantizar la confiabilidad y precisión de la información en un entorno empresarial.

4. Validez

La validez de los datos se refiere a que los datos deben ser recopilados de acuerdo con reglas y parámetros de negocio definidos, y deben conformarse al formato correcto y estar dentro del rango correcto. Esto significa que los datos deben ser relevantes y adecuados para el propósito previsto, y deben cumplir con las normas y estándares establecidos por la organización. Para que los datos sean considerados válidos, deben cumplir con las reglas y criterios establecidos por la empresa. Por ejemplo, si una empresa tiene reglas específicas sobre cómo se deben recopilar y registrar los datos de los clientes, los datos recopilados deben seguir esas reglas para considerarse válidos. Además, los datos deben estar en el formato correcto y dentro del rango correcto para ser considerados válidos. Por ejemplo, si una empresa recopila datos de temperatura en grados Celsius, los datos en grados Fahrenheit no serían válidos a menos que se conviertan al formato correcto. Garantizar la validez de los datos es fundamental para garantizar que la información obtenida sea precisa y confiable. Esto ayuda a evitar errores en los análisis y decisiones basadas en datos incorrectos. Para asegurar la validez de los datos, es importante establecer procesos y controles de calidad adecuados, así como capacitar al personal sobre la importancia de recopilar datos válidos y conformes a las reglas establecidas.

5. Unicidad

La unicidad de los datos asegura que no haya duplicaciones ni superposiciones de valores en todos los conjuntos de datos. En otras palabras, cada dato debe ser único y no debe repetirse en ningún otro lugar dentro de los conjuntos de datos. Para que los datos sean considerados únicos, cada valor o registro debe ser distintivo y no debe haber ninguna otra instancia idéntica en el conjunto de datos. Por ejemplo, si una base de datos contiene información sobre clientes, cada cliente debe tener un identificador único para garantizar su unicidad. Garantizar la unicidad de los datos es importante para evitar confusiones y errores en el análisis de los datos. Si hay duplicaciones, los análisis pueden verse distorsionados y las decisiones basadas en esos análisis pueden ser incorrectas. Para garantizar la unicidad de los datos, es importante establecer mecanismos de control de calidad que identifiquen y eliminen duplicaciones, así como asegurarse de que los sistemas de almacenamiento de datos estén diseñados para prevenir duplicaciones.

La limpieza de datos y la deduplicación pueden ayudar a remediar un puntaje bajo de unicidad. La limpieza de datos se refiere al proceso de identificar y corregir errores, inconsistencias y valores faltantes en un conjunto de datos. La deduplicación, por otro lado, implica identificar y eliminar duplicaciones de datos dentro de un conjunto de datos.

Cuando un conjunto de datos tiene un puntaje bajo en unicidad, significa que hay duplicaciones o superposiciones de valores en los datos. La limpieza de datos y la deduplicación son procesos que pueden ayudar a abordar este problema al identificar y eliminar las duplicaciones. La limpieza de datos puede involucrar la corrección de errores de entrada, como valores incorrectos o mal escritos, así como la eliminación de valores atípicos o inconsistentes. Por ejemplo, si un conjunto de datos contiene el nombre de una ciudad escrito de diferentes maneras (por ejemplo, “San José” y “San Jose”), la limpieza de datos puede estandarizar los valores para que sean consistentes. La deduplicación implica identificar registros duplicados dentro de un conjunto de datos y eliminarlos. Esto ayuda a garantizar que cada registro sea único y contribuye a mejorar la calidad y la unicidad de los datos en general.

6. Oportunidad

La oportunidad de los datos (conocido en inglés como Timeliness) se refiere a que los datos estén disponibles cuando se requieran. Esto implica que los datos estén actualizados y sean accesibles en el momento necesario para su uso en análisis, toma de decisiones u otras aplicaciones. Los datos oportunos son aquellos que se actualizan en tiempo real o con una frecuencia adecuada para cumplir con los requerimientos de la aplicación o análisis específico. Por ejemplo, en un sistema de monitoreo de ventas en línea, los datos de ventas deben actualizarse constantemente para reflejar las transacciones más recientes. La disponibilidad oportuna de los datos es crucial para garantizar que las decisiones se tomen con base en información actualizada y relevante. Si los datos no están actualizados o no están disponibles cuando se necesitan, esto puede llevar a decisiones erróneas o desactualizadas. Para asegurar la oportunidad de los datos, es importante implementar procesos y sistemas que permitan la actualización y disponibilidad en tiempo real de los datos cuando sea necesario. Esto puede implicar el uso de tecnologías de transmisión en tiempo real, la programación regular de actualizaciones automáticas o la implementación de sistemas de almacenamiento de datos que permitan un acceso rápido y eficiente a la información actualizada.

Conclusión

En conclusión, la calidad de los datos es un aspecto fundamental para el éxito de los proyectos de ciencia de datos en la era actual de la transformación digital. La calidad de los datos se refiere a la precisión, completitud, consistencia, validez, unicidad y puntualidad de los mismos. Estos criterios son fundamentales para garantizar que los datos utilizados en los proyectos de ciencia de datos sean confiables y puedan generar insights valiosos para las organizaciones. La mala calidad de los datos puede provocar que un proyecto de ciencia de datos, con muy buenas expectativas, salga muy mal o diferente de lo esperado. La famosa frase “Garbage in, garbage out” resume este concepto de manera concisa y efectiva. Esta expresión enfatiza que si se ingresan datos de mala calidad en un sistema, los resultados producidos por ese sistema también serán de baja calidad.

Cuando los datos utilizados en un proyecto de ciencia de datos son imprecisos, incompletos, inconsistentes, inválidos, no únicos o no oportunos, los resultados del análisis y las decisiones basadas en esos resultados pueden ser incorrectos o sesgados. Por ejemplo, si un algoritmo de aprendizaje automático se entrena con datos incorrectos o incompletos, es probable que las predicciones que genere también sean inexactas. La mala calidad de los datos puede llevar a una serie de problemas en los proyectos de ciencia de datos, como decisiones empresariales erróneas, pérdida de oportunidades de negocio, análisis incorrectos de tendencias y patrones, y una falta de confianza en los resultados de los análisis. Por lo tanto, es fundamental asegurar la calidad de los datos utilizados en los proyectos de ciencia de datos mediante la implementación de procesos y controles de calidad adecuados.

“La calidad de los datos es un aspecto crítico para el éxito de los proyectos de ciencia de datos.”